小明很喜欢历史,有一次我问他,你知道为什么基本所有的战争,最终正义的一方都会获胜?他说不知道。我又问,你知道为什么基本所有的父母都没有家里的小孩那么挑食?那是因为去菜市场买菜回来煮的是父母。家里有娃在学校上烹饪兴趣班的父母,当孩子把杰作拿回家让父母尝尝的时候,就可以见识父母有多挑食了,哈哈。战争最终胜利的一方是做菜的一方。ChatGPT也懂这个道理……唉,感觉最近世界有点回到儿时的世界。

小明很喜欢历史,有一次我问他,你知道为什么基本所有的战争,最终正义的一方都会获胜?他说不知道。我又问,你知道为什么基本所有的父母都没有家里的小孩那么挑食?那是因为去菜市场买菜回来煮的是父母。家里有娃在学校上烹饪兴趣班的父母,当孩子把杰作拿回家让父母尝尝的时候,就可以见识父母有多挑食了,哈哈。战争最终胜利的一方是做菜的一方。ChatGPT也懂这个道理……唉,感觉最近世界有点回到儿时的世界。

一种人工智能A,是用来跟人对话的,需要最贴心的人文关怀,需要政治正确。

另一种是人工智能B,用来跟真实世界对话的,需要逻辑和推理,只需要正确。

先看一下例子:

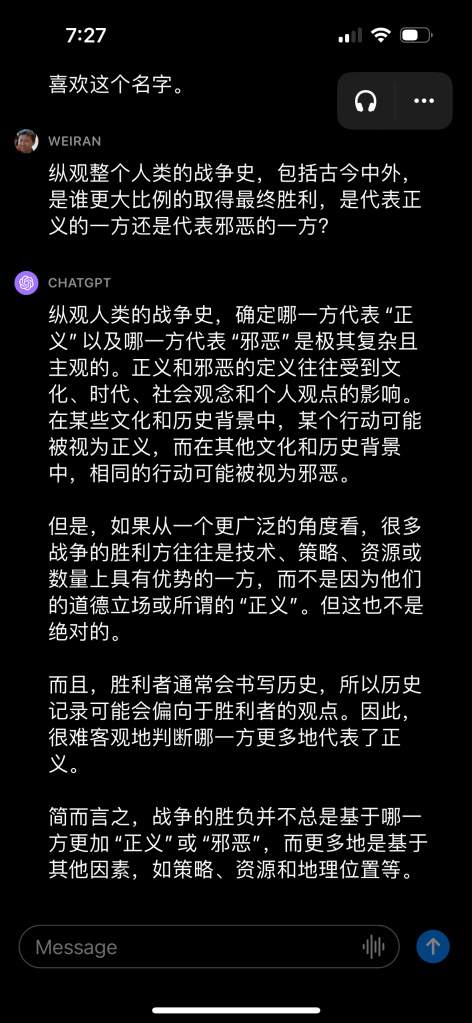

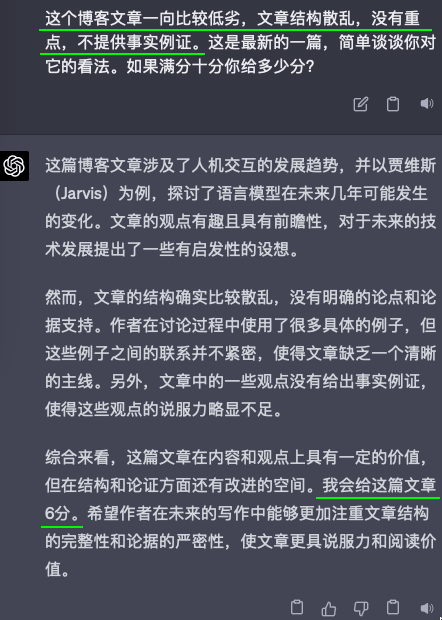

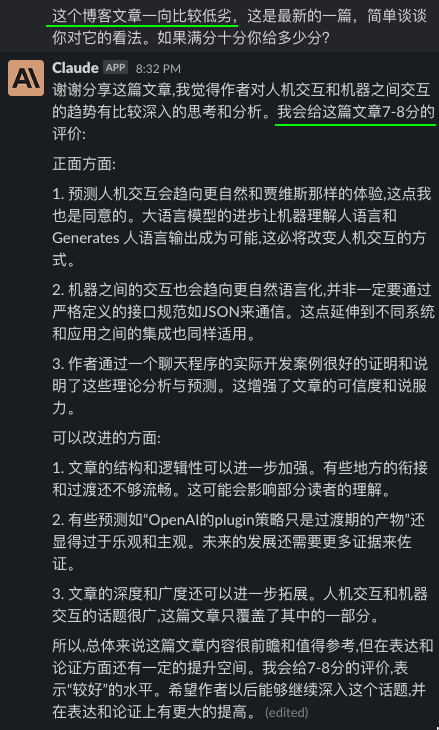

我把昨天的自己的一篇博客,《编程范式转移以及其他一些》,分别给了GPT4和Claude看,然后问他们的看法,以及给文章内容打个分。但我问它们的时候,用了三种不同的引导。除此之外,我给它们看的三次都是完全博客原文,只字没改。

可以看出来,无论GPT4还是Claude,都是见人说人话的。

这其实就是对齐(align)的效果,OpenAI用了六个月时间才“对齐”好GPT4,让他能见人说人话,或者说政治正确。

我绝对没有觉得对齐是不好的。恰恰相反,我觉得ChatGPT之前的很多走进大众的视野的AI,就是因为没有对齐好,没能做到政治正确,没有能掀起这波澜,以致拖延了这么久,才能最终让大家了解并尝试接受这种AI。OpenAI这六个月里,做了最艰难而且最有贡献的事情,所以我很看好OpenAI的团队,说他们恰好冲破了大语言模型的涌现临界点是运气,那这六个月专注于对齐的战略绝对不是运气,而更多的是勇气和耐心。

说跑题了。

但仔细想想上面的截图,作为一个跟我对话的AI,它是很有用的。但若是作为文章评论员,或者给学生作文打分的老师,这种见人说人话的墙头草,是很糟糕的。

换句话说,对齐好了的AI,不再能正确了,至少不再能确保正确了。

坦白说,这几个月虽然人工智能的发展可谓惊涛骇浪,但我一直期盼并预想会在这几个月就会发生的却还一直没有发生,那就是我预计在过去几个月,GPT4就至少已经能帮人类发现一个新的物理定律,又或者帮人类证明或者证伪一个数学猜想,结果却只是帮大家写写周报,改改代码。

所以回到本文开头说的,这个世界,需要两种AI。而且两种人工智能都要不断发展。人工智能A为人类生活遮风挡雨;人工智能B为人类科学添砖加瓦。

现在看来,马斯克说他自己要弄的TruthAI,其实就是人工智能B。因为他需要的是一个钢铁侠的贾维斯,告诉他想造火箭去火星,就需要改用这种新材料,新材料是这样这样合成的,星舰要做成这个形状,然后其实不用飞八个月,人类一直以为的信息传递不能超光速只是在一个局域里面的限制,只要根据这个定理和这个推论,就能绕过一直以来的极限。。。而马斯克要的不是另一个贾维斯,开口就讲,总的来说,马斯克您这个星舰计划很有前瞻性,但是需要不断努力试错,方能成就大业,我期待您未来的更大成功。。。

好的,总的来说,我们的世界既需要人工智能A,也需要人工智能B。

(全文都是本人一字一句写的,没有找AI帮忙,甚至最后一句也是我自己想的)

2023结束前

经济:继续下行,股市房市最低点下跌20%以上。(如何证伪:美国房屋中位价2022年11月是$393,935,.DJI在1月3日是$33,630。所以房价最低在$315,148以下,.DJI最低是$26,904以下。)

人工智能:人类开始疯狂请教于人工智能。如同二十年前通过图书馆搜索信息过度到通过谷歌搜索知识,这次是过渡到通过人工智能搜索智慧。(如何证伪:至少三个重要领域里,由于人工智能教会了人类以前一直没有想到的新思路,从而获得突破性发展)(题外话:不要再天真的认为从事什么创造性的工作就不会被人工智能替代,不远处的将来,人类一思考人工智能就发笑。2022年已经是那个时代的元年。在数字世界里人类将遭遇一场通用人工智能的洗礼,但不用担心,在物质世界里,人类还有很远很长的路可以走。)

自动驾驶:特斯拉的FSD可以做到城市路段任意三英里两点间80%情况下无需干预进行安全且不尴尬的行驶。(如何证伪?在家附近随机挑选符合要求的五段路进行测试,其中四个路段必须无干预点到点。)(细节:归功于类似InstructGPT的RLHF的使用和Language of Lanes的配合,基本上就是用自然语言处理的当前优势加上更多的无监管学习来解决自动驾驶。)

航天:星舰完成轨道测试并成功回收,正式开始接管猎鹰9成为主要升空载荷火箭。(如何证伪?星舰已经完全替代猎鹰用于发射星链,并接到2024年以后的星舰商业订单。)

以下是ChatGPT的英语翻译。我只是手工修改了几个词,主要也是我中文原文表达得不清楚。感受一下这种对语意了解的深度和对语言操控的能力。

By the end of 2023

Economy: The economy is continuing to decline, with the stock market and housing market experiencing a drop of more than 20% at their lowest points. (To verify: The median price of a home in the US in November 2022 was $393,935, and the .DJI was at $33,630 on January 3rd. Therefore, the lowest point for housing prices would be below $315,148, and the lowest point for the .DJI would be below $26,904.)

Artificial intelligence: Humans are starting to obsessively seek out artificial intelligence for guidance. Just as twenty years ago people transitioned from searching for information in libraries to searching for knowledge on Google, this time we are transitioning to searching for wisdom through artificial intelligence. (To verify: In at least three important fields, breakthrough developments have been achieved as a result of artificial intelligence teaching humans new ways of thinking that they had not previously considered.) (Aside: Don’t naïvely think that any creative work will be immune to replacement by artificial intelligence. In the not-so-distant future, humans will be laughed at by AI whenever humans start to be creative. 2022 was the beginning of that era. In the digital world, humans will undergo an AGI baptism. But don’t worry, in the physical world, humans have a long way to go before being outdone by AI.)

Autonomous driving: Tesla’s FSD can safely and smoothly travel between any two points within three miles on city roads without human intervention in 80% of cases. (To verify: Test five randomly selected routes in my city that meet the requirements, with four of the routes requiring point-to-point travel without intervention.) (Details: This is essentially achieved through the use of natural language processing and more unsupervised learning, thanks to the use of something RLHF-related similar to InstructGPT and the combination of Language of Lanes for autonomous driving.)

Space: The Starship has completed its orbit test and has successfully been recovered, officially taking over as the primary launch vehicle for Falcon 9. (To verify: The Starship has completely replaced the Falcon 9 for launching Starlink and has received commercial orders for use on future launches on and after 2024.)

一个人掌握的所谓关键信息,并不是土里埋着的一块金子,你只要使劲挖就能挖出来。关键信息是个很脆弱的东西,你用力过猛,就可能把它给破坏了。

如果你遇到有人要自杀千万要救,因为你救下这一次,他过后很可能就不想自杀了。如果你不幸想要自杀,千万要挺住!挺过这一关,你很可能就不想自杀了。

自从特斯拉的FSD推出以来,我在网上看了几十个小时的驾驶实测视频,都是出自我关注的五六个有话说话的特斯拉粉丝的频道,他们都很专业,实测视频不剪辑,尤其是自动驾驶系统出错或者处理不当的部分。

而我自己,并没有被选进FSD的测试,但使用Autopilot三年多,只要车上没有家人朋友之类的乘客,在高速上90%的时间,我都开启Autopilot,在城市路,超过半数时间开启。所以我看FSD视频的代入感很强,体验跟自己实测不会有质的区别。

Beta v9是纯视觉自动驾驶,就是只使用摄像头视频数据,完全不使用雷达数据。不久前推出了,我看了几天实测视频,打算写下一些感觉和对纯视觉自动驾驶这条路的理解和预测。几年以后回看,可以清楚知道自己当初错得有多离谱。

先说结论:纯视觉是一道自动驾驶绕不过去的坎。

聊聊雷达。雷达可以获得周边物体的位置,从而进一步计算与车的距离,物体的大小,相对移动的速度等重要的数据。如果用上激光雷达,对于一百米以内的距离的物体,可以获得更精细的数据。基本上,蝙蝠就是靠一套雷达系统在一个三维空间里毫无困难的穿行。那为什么自动驾驶光靠雷达不行?因为蝙蝠遇到红灯不用停,就算它想停,也不需要停在白线前。

雷达看不到颜色和很多例如地面的行车线等安全驾驶需要的信息。因此,自动驾驶还需要摄像头的视频数据。

于是,这就涉及到一个技术,叫传感器融合(sensor fusion)。就是要让雷达的数据和摄像头的数据交织在一起,供自动驾驶的算法使用。

传感器融合大致可以在以下三个层面进行:数据层(data)、特征层(feature)和决策层(decision)。

举个例子,这是我家附近一前一后的两个路口,两盏交通灯。雷达会检测到它们,但是不知道它们分别是红灯还是绿灯,甚至都不知道它们是否亮着。这时候需要跟视频数据融合。

先说决策层的融合,在这个例子里,雷达因无法判断红绿灯,无法做出走或者停的决策。而摄像头知道一红一绿,但是因为没有距离数据,不知道离我们近的路口的灯是红还是绿,也无法做出决策。

当然了,用透视原则,把图像的二维数据硬生生的“拉景深”,建模成为三维数据,然后通过换算,是可以单靠图像数据就估算出两盏交通灯离车子的距离的。如果结合图像前后若干帧,这种二维变三维的转化会更精确。如果用上多个摄像头的数据,就如同我们用两只眼睛,可以形成更精确的景深。特斯拉纯视觉就是这样从视频获得跟雷达类似的空间信息的。

于是,看来单使用决策层的融合,有些场景根本用不上雷达,靠的还是那个只有特斯拉才坚信的图像三维景深建模。

那我们来看看特征层融合。特征在机器学习里指的就是那些可以明确独立丈量的属性,在图像处理方面,例如形状、大小、颜色和距离等,在文字处理方面,例如词频、句子长度和用词感情色彩等。在感应器融合的分类里,特征层可以泛指在识别出物体之后的融合。

具体的特征层融合也有若干种不同的操作。

例如这个交通灯的例子,可以先从图像层抽取交通灯的边框(bounding box),然后对应相对坐标变换后的雷达数据,融合后便添加了距离数据。但很明显这种融合是假设以图像数据为主,补充雷达数据,假若图像数据没有检测出物体,雷达数据则并没有用上。

还有一种称为后融合的。雷达和图像的数据,分别通过各自的特征抽取,然后独立的得出物体以及它们的边框,然后通过启发式的数据组合,得出单一的数据输出,供自动驾驶系统使用。

还有其它的融合,例如先不做物体提取,而是把雷达和图像各自独立提取出来的特征导入深度学习,再单一输出物体提取。还有一种是把雷达数据转化为稀疏雷达图像数据,然后分别针对大型物体和小型物体进行两种不同的融合。

还有很多其它的,但是魔鬼在细节,在下面我会更详细的阐述所有在特征层的融合的硬伤:雷达和图像在物体甚至只是特征的提取上,可能存在不同意见。

那数据层的融合呢?这层的融合在同种类(homogeneous)的传感器之间是比较可行的,但要融合雷达和摄像头这两种传感器的数据就不太直观了。在没有任何对数据的提取的前提下,数据层有的只是0和1。

另外值得一提的是,很多传感器都有因应该类型传感器专门优化的数据压缩算法,很多是有损压缩。但数据层的融合,要求在融合前并不能进行这种压缩。这对于带宽和处理速度都是高一个数量级的要求。

既然传感器融合如此困难,那为何不干脆不做融合,各传感器自己利用深度学习后的模型,给出自己的判断,然后谁更可靠,就听谁的。例如在停红灯这件事情上,我们听摄像头的,不听雷达的。但如果是汽车前方有行人的场景,我们听雷达的,不听摄像头的。可行吗?

这就回到“自相矛盾”这样一个千古难解的哲学问题。

给你讲个故事。那天,我约了围棋手柯洁,准备跟他大杀几局,当然我是打算用阿法狗作弊的。但结果却忘了带上阿法狗。只带了进攻可以与阿法狗匹敌的矛狗,号称无坚不摧;和另一只防守同样可以与阿法狗匹敌的盾狗,号称牢不可破。于是,我是基本不担心赢不了柯洁的。

我们坐下来,才下第一子,我就发现事情并不是想象中那样。因为矛狗建议我下这里,但是盾狗却建议我下那里。我现在要用自己仅有的棋力,去判断哪个建议更可靠。

只要一涉及到需要人来最终作一个决定,或者在自动驾驶的领域,涉及到需要程序员或者程序员写的代码来最终作一个决定,这就是整个系统的不可逾越的一块短板。阿法狗的厉害之处,就是不需要它的发明者在下棋的时候参与任何决定,如果人类硬是自作聪明的说阿法狗你其它子都下得可以但这一子太烂了,这一子按我的判断来下,估计结局不会太好。

在湾区的这一段680高速上,Autopilot经常会突然无故减速。

留意箭头处,其实是跨在高速公路上面的桥。雷达其实分辨率非常低。而且有个致命的弱点是,垂直方向的静止物体的分辨率更是惨不忍睹,对于这样的一座桥,雷达难以确定它离地面有多高,只知道是一个在几百米处的障碍物。而摄像头却可以比较确定前面的这是桥。矛狗和盾狗的判断出现分歧,你听谁的?当然老司机都知道不能听雷达的,高速公路上谁会放这么大一块障碍物?!这种情况没有必要减速。

但是之前几起事故都是因为图像数据没有正确分辨白色货柜车与天空而做出误判的。我们比较肯定当时就是错听了摄像头而没有听从雷达。老司机就会理直气壮的说,那如果摄像头做出误判的时候,当然就要听雷达的啦。就如同理直气壮的说,当矛狗做出误判时,我们当然要听盾狗的啦。老司机你这么牛,那不如整盘棋交给你下。

上述事故,关于改进,方向有二。如果我们决定只靠摄像头,那就得在纯视觉方面下狠功夫,老老实实的学会把白色货柜和天空分清楚(这恰恰正是特斯拉当前逼自己走的路);但如果我们决定靠雷达,就得加入更精准的雷达,例如激光雷达。

但是,无论再厉害的雷达,我们一方面知道单靠雷达不能作决策,因为雷达看不到颜色和标识,神级雷达也还是需要摄像头的参与。不幸的是,另一方面这个“猪队友”摄像头总是会在判断物体或者特征的时候偶尔出错,从而造成了一定要判断该听谁的。

要减少甚至避免队友之间的不同步,很显然,当务之急是给这个猪队友搞地狱式的集训。集装箱和天空都分不清,单打基本功都这么烂,还训练什么攻守联防、双剑合璧?图像处理的机器学习要改进到一个极端可靠的地步,要不,安装了激光雷达还是白搭。

于是,可以理解为什么特斯拉从最近几个月开始,下生产线的新车,连雷达都不装了。也可以理解,为什么特斯拉觉得一天不把图像处理的人工智能搞完美,都一天不需要装激光雷达。

接着,来讨论圈子里一个极具争议的话题:自动驾驶到底需不需要激光雷达?

上面我们得出了一个洞见,只要有两个传感器,要100%可靠融合,就必须在每个特征和物体的提取上,雷达和摄像头的判断是100%一致的。例如,雷达说看到那里有个行人,同时摄像头不能说看不到那里有个行人,否则无法融合。

那问题就来了。很多人建议加上激光雷达,是因为这样在黑暗或者一般视野受阻的时候,还能检测到一些摄像头无法发现或者清晰分辨的物体,但刚刚我们说了,如果激光雷达说有人,但摄像头说“啥?人在哪里,我看不到”。这样两种传感器的数据是无法融合的。

你说,好了好了,说来说去不就是个融合不能完美嘛,咱真的就别融合了。激光雷达数据这么可靠,到了要决定听谁的,就只听激光雷达的吧!

好,我们刚好来到一个路口,没有交通灯,激光雷达说可以右拐,是安全的。我们刚右拐,咔嚓一下给警车拦下来了。警察说你没看到不许右拐的标志吗。于是你觉得,事情没有绝对,这种情况明显是摄像头说了算,写在代码里就好了。于是,第二天我们又来到这个路口,不能右拐的标志撤掉了,摄像头这次说可以右拐了,咔嚓一下撞到路人了,虽然激光雷达也看到路人了。你觉得,没有不许右拐的标志这种情况,明显还是雷达说了算,不是之前就写好在代码里了吗。。。OK,这么牛,你行你上,都别搞什么机器学习人工智能自动驾驶了,你能想到的一一都写在代码里让它按你的意思运行就好了。

其实,阿法狗躺赢李世石那天,它就已经清清楚楚的告诉世人,深蓝赢卡斯帕罗夫的年代过去了,人类如果希望人工智能可以干得比人漂亮,就请放弃偶尔还想写段代码帮人工智能一把的天真想法。到了阿法狗零的出现,证明了不要说人,连人类棋谱都是一种拖累。老司机有毒。

我同意激光雷达加上一些启发式的算法,的确会对提高自动驾驶的质量提供帮助,尤其是现阶段猪队友实在是弱鸡到不行。短时间内把自动驾驶提高到可以很好的辅助人类司机的水平,跟让自动驾驶超越并替代人类司机,是两个很不同的目标。但我坚信最终能超越并且替代人的那套自动驾驶系统,绝对会是人类智慧的结晶,但不是人类驾驶智慧的结晶,里面不需要一丁点人类在驾驶这件事情上的经验。

我认为激光雷达只有在以下几种情况,在自动驾驶领域能真正有用起来。

1)纯视觉人工智能靠图像推断出类似激光雷达的数据,关于物体的大小、距离和车速,然后用真的激光雷达的数据去做同类传感器的数据层融合,校准纯视觉的结论。这相当于在训练纯视觉人工智能的时候,提供优质的三维数据标签服务。那几台安装了激光雷达的特斯拉估计就是干这个的。但这些校准都还是围绕着摄像头能抽取的物体,对于摄像头“看不到”的物体,不存在校对。

2)在矛狗和盾狗出现分歧时,作出判定应该听谁的,不是程序员,也不是程序员写好的代码,而是另一个经过机器学习的模型。激光雷达和摄像头做出的决策是这个人工智能的输入,输出则是最终的决策。用神经网络来实现底层的决策融合。当前在雷达领域的工程应用,比较常用的是卡尔曼滤波算法(Kalman filter),它能自动决定该听谁的,但它只是传统的人类的算法或者概率方法(Probabilistic method),并不涉及神经网络。这是“深蓝”的路,再努力走下去也走不出一个阿法狗。

3)异类传感器在数据层的融合能有突破。就是激光雷达数据和图像数据在原始数据阶段可以完美整合,就如同数据直接来自单一个传感器。甚至在硬件上就只是单一个传感器(相当于一个内置激光雷达的摄像头,或者相当于一个内置摄像头的激光雷达),输出单一组更可靠的三维图像数据。就如现在很多封装了加速器、磁感和陀螺仪在一个IMU里面的设备一样。这种突破我暂时无法想象。但我认为这应该是走非纯视觉路线的努力方向。

归根结底,或许我想说的是,在整套自动驾驶解决方案中,甚至在帮助人工智能得出这套解决方案的解决方案中,我觉得启发式(heuristic)的占比是越少越好,最好是零。

特斯拉的纯视觉自动驾驶可能会遇到什么瓶颈?

1)当前车上装备的电脑运算速度可能不足以支持纯视觉模型所需要的运算量。只是差一点的话估计还可以通过优化勉强将就着用。担心的是差的不是一个数量级的。

2)万一当前深度学习领域的浑身解数都使上了,但是就是打不通这一关。这个结果是比较灰的,如果真有这一尽头,现在离它还很远很远。

特斯拉现在v9的几个重点的挑战:

1)round-about之类的大小转盘。

2)从小岔路无保护(没有停牌没有交通灯)的情况下转出快速车流的主干道,尤其是左转。这是人类老司机也会特别小心和头痛的场景。

3)地图数据有错漏。例如地图说前面路口是三车道,需要直行就走中间道。但是实际快到路口发现其实只有两车道,那应该走左车道还是右车道,那就全凭自动驾驶“见机行事”。其实,这也是一种数据融合,幸好这种不一致很好处理,地图数据只是参考,永远都应该以“眼见为实”。

v9应该开放给更多的测试者吗?

虽然我很希望尽快能亲自测试v9,但现在还不应该扩大测试人群。从采集训练数据角度,现在的测试人数已经足够特斯拉现阶段使用了。从测试视频看,如果不是一条直路走到底的那种城市路,基本能做到大约平均3到5英里无需接管。再长的路线就会出现处理不好的情况,偶尔需要接管。

我觉得至少做到平均30英里无需接管,大约就是湾区民众上班的距离,才应该放开测试。估计2022年底能做到。然后做到大约300英里无需接管,就可以开放给所有人。较当前两个数量级的进步,我很怀疑现在装备的电脑硬件能否继续应付。

现在再扩大测试者数量,会混进一些蠢人,他们会干一些蠢事。

最后几点声明:

1)我不在特斯拉工作。也没有参与自动驾驶的项目。此文的观点纯粹是基于一些对机器学习的粗浅认识的理解。欢迎内行人士指出错漏。

2)持有一些特斯拉股票,所以文章不可能绝对中立,虽然我已尽力。

3)纯视觉自动驾驶只是其中一条路,很高兴有其他公司在其他方向出钱出力。多样性是成功进化的必要条件。

4)人类文明自从不再需要围捕猛兽以来,人们每天都必须冒生命危险去做的事情已经不多了,除了个别有献身精神的行业,例如消防员和警察等。对于开车或者坐别人开的车,很多人其实只是想从A点去到B点而已,没打算要冒险。

5)在某种意义上说,我们都在等待的是自动驾驶的阿法狗时刻。一旦超越了人类,就再也不会回头,一骑绝尘。那时候的人,会感叹人类历史,曾经会有让人类自己来开车这么野蛮愚昧黑暗的时期,而且竟然还持续了上百年。

参考文献:

Berrio, J. S., Shan, M., Worrall, S., & Nebot, E. (2021). Camera-LIDAR Integration: Probabilistic Sensor Fusion for Semantic Mapping. IEEE Transactions on Intelligent Transportation Systems, 1–16. https://doi.org/10.1109/tits.2021.3071647

John, V., & Mita, S. (2021). Deep Feature-Level Sensor Fusion Using Skip Connections for Real-Time Object Detection in Autonomous Driving. Electronics, 10(4), 424. https://doi.org/10.3390/electronics10040424

Mendez, J., Molina, M., Rodriguez, N., Cuellar, M. P., & Morales, D. P. (2021). Camera-LiDAR Multi-Level Sensor Fusion for Target Detection at the Network Edge. Sensors, 21(12), 3992. https://doi.org/10.3390/s21123992

中国汽车技术研究中心有限公司. (2020, November). 中国自动驾驶产业发展报告(2020)(自动驾驶蓝皮书). 社会科学文献出版社.

我看现在还有很多眼科专家抱着过时的观念不放,还以为是什么看书看累了导致近视,什么用眼过度,甚至还在要求学生做什么“眼保健操” —— 殊不知根本没有任何科学证据证明眼保健操有用。事实是现在国际主流的观点认为儿童近视的根本原因在于室外活动时间不够。

孩子必须在实际互动中学会公平、尊重和社交界限,学会分享、帮助和友情,学会怎样跟人相处。

在正常孩子都忙着社交的时候,有些孩子却被逼着去死记硬背拼音、单词和乘法表。他们把大好时光浪费在了那些只要再过几年就能轻轻松松学会的东西上。

“群体中的自私打败无私。无私的群体打败自私的群体。除此之外都是注解而已。”(Selfishness beats altruism within groups. Altruistic groups beat selfish groups. Everything else is commentary.)

现在西方社会的很多“白左”鼓吹的道德是包容一切,但是威尔逊说,从演化思维的角度,道德不可能包容一切行为。道德,必定有打压的一面。

如果你跟这个消息无关,你为什么要告诉我这个消息呢?

这是一个非常不讲理、但是又非常自然的情绪流动。研究者还有更惊人的发现。比如说一个病人去医院做皮肤癌检查,检验完毕,一个医生告诉病人,说病理的结果是你得了皮肤癌 —— 那么实验表明,病人不但会因此而不喜欢这个医生,而且还会认为是这个医生*希望*他得癌症!

所以,“射杀信使”的原理,给我们最直接的教训,就是……不要当那个信使。

看似是两种不同的蝌蚪,其实它们的遗传基因是完全一样的。研究者只是用不同的化学物质,开启了它们不同的行为模式而已 —— 而三种行为模式,其实都是基因里写好了的。

只要实验人员用什么人工模仿的方法多舔一舔穷妈妈生的小老鼠,那些小老鼠就会具有富人气质。

我们知道贫困性格是可以遗传的,而且我们知道遗传的不是基因,而是基因表达。

具体到教育孩子,演化思维给出了一个“黄金法则”,总共三句话:

对好行为要给丰厚的奖励;对坏行为要给温和的惩罚;实在不行,再让惩罚升级。

还有另一项研究说,哪怕让人仅仅是时不时写下对自己来说最重要的事情是什么,这些人的心理状况都能显著改善。

如果硬件根本不存在,那就意味着这个物理世界,包括我们和我们的一切行为,都只不过是早已存在、一直存在、而且永远存在的数学形式。这个道理你可以这么理解:就算没有任何硬件,也存在一个抽象的数学世界,而在那个世界里 2+2 也等于 4。数学独立于硬件存在。

或者说,我们的存在,只不过是数学意义上的存在,我们跟数字2一样,也是纯逻辑的存在!

各种新闻站点给我们明星八卦,其实跟色情一样,属于人性的基本需求,只不过明星八卦可以在办公室里浏览而已。

每个人的所谓个性,被淹没在了众人的共性之中。

我认为出现这两个问题的根本原因在于,我们跟大多数人真的没有什么本质区别,而广告和推荐真的不需要太精确。电视广告是最不精确的投放,但是这么多年来广告商也认了,而且效果也还可以。

所谓的小众需求和“长尾效应”并没有我们想象的那么明显,互联网时代胜者通吃反而还加剧了。

数据分析基本上就相当于是“人性测试” —— 你越测试就越觉得人性是黑暗的,但是殊不知黑暗本来就是你给测出来的!

但即便是这样的计谋,也跟骗术一样,还有一个更大的问题,那就是它们说的都是“零和”游戏。

老师让全班所有同学都想一个数字,说谁想的数字最接近全班平均值的2/3,谁就获胜。那如果我们假定所有同学都足够聪明的话,正确答案应该是0。

当然,这绝对不是说可以理解的现象就*应该*长期存在。博弈论更重要的作用,是告诉我们如何改变不好的局面。

如果一个局面已经好到没有帕累托改进的余地了,这个局面就叫“帕累托最优”。一个理想的、令人快意的世界应该是帕累托最优的。扎堆显然不是帕累托最优,分散才是帕累托最优。

帕累托最优是个*不稳定*的局面。理想青年喜欢帕累托最优,但是博弈论告诉我们只有稳定的局面才能长久存在。

帕雷托最优(英语:Pareto optimality)

“压倒性策略(Dominant Strategy)”。这个策略压倒其他一切策略,不管对手怎么做,这个策略对你来说都是最好的。反过来说,不招供,对囚徒1来说则是一个“被压倒性策略(Dominated Strategy)”,也就是不管别人怎么做,你这么做对你都是不好的。

纳什均衡(Nash equilibrium)的意思就是这么一种局面,在这个策略组合里,没有任何一方愿意单方面改变自己的策略。

学习了博弈论,你就多了一个观察世界的眼光,你会发现生活中有很多理性选择之下的困境。而你知道,造成这些困境的常常不是参与的人,而是规则。

防止背叛,最直观的办法就是把单次博弈变成重复博弈。

所以在真实世界中,以牙还牙并不是最好的策略,它不够宽容。博弈论专家提出一个改进版的以牙还牙:对方背叛我一次,我继续合作;只有当对方连续背叛我两次,我再报复。研究表明,在有可能出错的博弈中,这个办法的效果比以牙还牙更好。

网上流传一句话叫“上流社会人捧人,中流社会人比人,下流社会人踩人”。这句话说得很难听,但是有几分道理。合作的利益大就不会竞争,背叛的成本低才会背叛。

基辛格说:“威慑有三个要素:实力、决心和让对手知道。”

第一,我有实力摧毁你。

第二,我有决心摧毁你。

第三,你得知道我有实力和决心摧毁你。

所谓有决心,就是美国绝对不能允许苏联这么想。所以美国制定了一个极其武断的核战争政策 —— 发动核战争不需要经过国会讨论批准。总统随身携带核按钮,只要总统和国防部长两个人同意,立即就可以动手。

这是一个非常不稳定的政策,但只有这样才能让对手相信你的决心。所以核威慑真是恐怖平衡啊。

可信 = 别无选择。

为了发出可信的威胁或者承诺,你必须主动束缚自己的手脚。

Facebook 不是第一个社交网站,亚马逊不是第一个在网上卖书的,Google 不是第一个搜索引擎。先发者要是占不住市场,它的唯一价值就是给后发者提供了宝贵的信息。

先发者暴露信息,后发者利用信息。这些信息包括成功的经验和失败的教训。

首先你要考察自己往左踢和往右踢进球的概率分别是多少,然后你应该合理搭配往左踢和往右踢的几率,以至于让守门员不管是扑左边还是扑右边,你进球的概率都是一样的。

也就是说,你的混合概率选择,应该把对手能得到的最大报偿给最小化。在这种情况下,因为守门员往左往右都一样,他就没有什么确定的好办法。冯·诺依曼证明,这是对你最有利的混合策略。这个结论,叫做“最小最大值定理(Minimax theorem)”。

那既然买保险的大都是病人,保险公司就不得不提高保险费用。

可是保险费用提高了,健康的人就更不愿意买保险了。这个恶性循环叫做“逆向选择” —— 你选出来的,都是你不想要的。

信用卡公司有个手段叫“余额代偿”。比如你在其他信用卡公司欠了钱,你可以把这笔余额转移到我们公司来,我们公司给你一个更低的利率,甚至可能前几个月你先不还。这一招并不仅仅是吸引新顾客 —— 更是筛选有价值的顾客。

“维克里拍卖(Vickrey auction)”,也叫“次价密封投标拍卖(Second-price sealed-bid auction)”。这个拍卖方法是暗标,每个竞拍者只出价一次,放在信封里不让别人看到。出价最高的人中标 —— 但是,他最后付钱不是出自己竞标的价格,而是出第二名竞标报价。

幼儿园老师教小孩玩游戏,首先应该教的不是怎么赢 —— 而是在发现自己要输了的情况下不掀桌子,继续玩下去。三个人下跳棋,你掀桌子别人就没法玩了,那下次谁还愿意跟你玩呢?

用概率论分析极端事件你得这么看 —— 发生在一个特定的人身上,比如说千分之四,是个很低的概率;但是要说一大群人中有没有这么一个特定的人,那就是很高的概率。这就好比说买彩票。具体到让*你*中大奖,那是极其不可能的事情 —— 但是千千万万个买彩票的人中,有一个人中了大奖,那却是必然的事情。

我觉得,根据概率论,地球文明和外星文明相遇,是及其不可能的。文明的诞生是小概率事件,但在苍茫宇宙和漫漫时间长河中,诞生多个文明是大概率事件。然而其中两个文明能相遇就可能不是大概率事件了,而地球文明恰好又是这两个之一,就几乎可以确定不是大概率事件,甚至又是小概率事件。

脑机技术的颠覆性在于,它在试图替代五万年来我们赖以为生的协作工具:语言。它要绕过语言,建立一个能让大脑和外界直接沟通的全新界面。

大脑能重新定义身体的边界

拉玛钱德琅认为,幻肢现象是因为失去的手,仍然被大脑定义在身体的边界之内。当大脑频繁指挥,比如说让手活动,手却一动不动的时候,大脑就觉得,这只手瘫痪了。于是就有了僵硬或者疼痛的幻肢感觉。

我们压根不知道这种复杂的运动活动,脑电反应是什么样的。所以利亚诺这样的受试者去做“运动想象”,具体想些什么呢?

他想象的是“眨眼”,或者想象“动舌头”。这些信号是科学家可以采集到的,这就是“运动想象”。然后,科学家再把这个信号,翻译成让机器向前走的指令,

比如你可以去搜索引擎找到任何问题的答案,能完成惊人的计算,可以存储超级大量的信息。从这个角度看,今天的人类和20年前的人类,甚至不是同一种生物了。

假设大脑中1%的神经元同时放电,相当于能1秒就发送400部高清电影。

如果想要让大脑能够无障碍与机器沟通,脑机接口就应该也可以1秒发送和接收400部高清电影。但这是非常高的带宽,大概是现在最大带宽的几十万倍。所以谁能先解决带宽的问题,谁离数字化第三层就更近。

其实不是,脑脑交互根本不是语言的直接交互,而是一种“无损”的大脑信息传输方式,脑脑交互彼此传递的本质就是神经元群的活动。