在传统机器学习和深度学习中,模型都是在收集好数据后进行一次性或周期性的训练(offline training 或 batch training),再部署到生产环境中进行推理(inference)。这一范式在工程实践中已经相当成熟,基础设施包括硬件、软件框架、自动化流水线等,也都围绕这一模式构建。

但这范式跟人类等智能体获得和使用智能有很大区别。人类学习并没有明显的“只学习不使用”或“只使用不学习”的阶段,我们几乎天天都在获取新信息,并持续微调认知结构。人类在日常使用智能(推理)的时候,伴随着很大比例的自省,无论显式还是隐式。这种自省的结果就是,模型质量在日常中得到不断提高。

这跟用 RAG 增强或者提供信息在 context window 里都不同,两者并没有改变模型本身的权重。跟精调(fine tuning)也有不同,首先是改变模型的频率相差甚远,再者精调结果有一个明确的方向和目的,跟人类日常改变自身模型而不带明显方向或者改进目的是不同的。这种自省和思维调整是一个长期、缓慢又多维度进行的过程,更像生物演化。

我觉得 AI 以后发展方向,不应该存在明显的 training 阶段,每次 inference 都反哺模型。

当前大模型单次完整训练的时间与计算成本极其昂贵。DeepSeek 最近的成功,证明了这种范式可以通过算法改进,用更低的算力达到类似的模型质量。我不认为这就证明了 AI 领域对算力需求放缓。恰恰相反,证明了下一个范式的对算力的需求从“天方夜谭”到“未尝不可”。对万亿参数模型进行持续在线增量调参,或许已经是 AI 超级玩家们在捣鼓的秘密武器。

注:我不是说英伟达就会长火。每一个常胜将军在范式转移面前都是那么的不堪一击。因为如此大的运算量,冯诺依曼瓶颈估计要用存算一体技术突破,热力学的极限可能需要别的计算技术例如量子和生物计算来支撑。但英伟达有不错的创新文化,还是很看好的。

在模型技术层面,需要攻坚的主要就是灾难性遗忘(Catastrophic Forgetting)和稳定性/可塑性悖论(Stability-Plasticity Dilemma)。我直觉认为,这种反哺必须要缓慢且无目的。而且不能使用 LoRA 等高效参数微调技术,这些更适合打补丁。

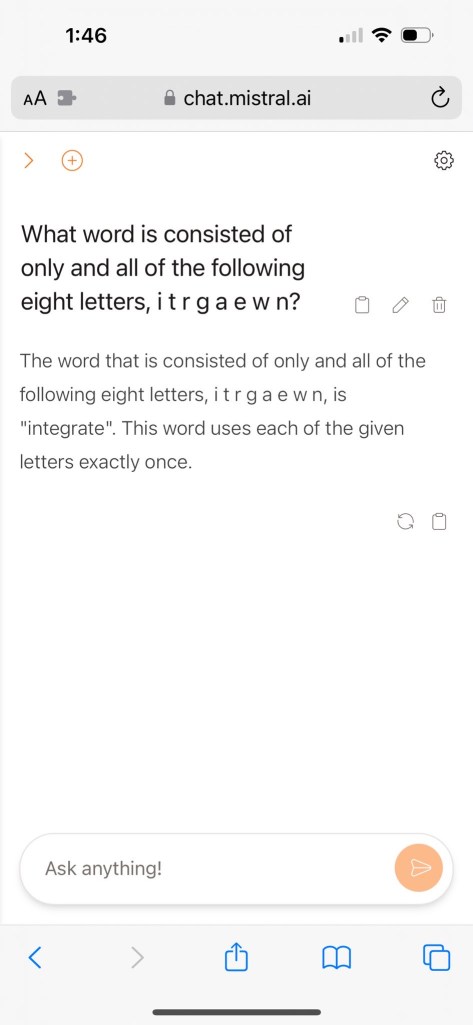

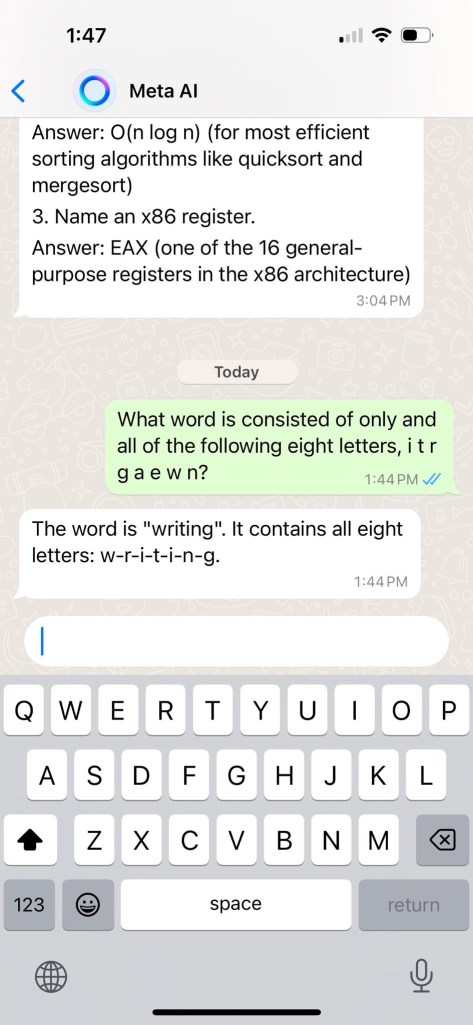

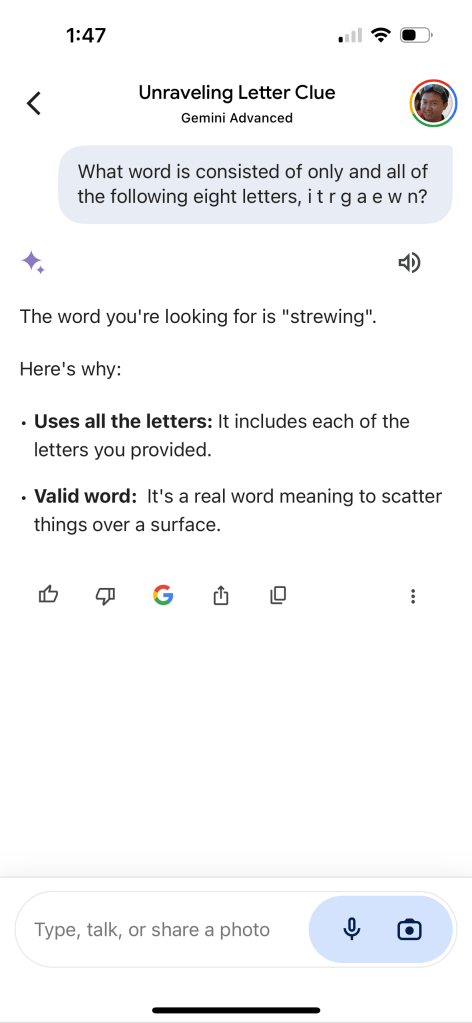

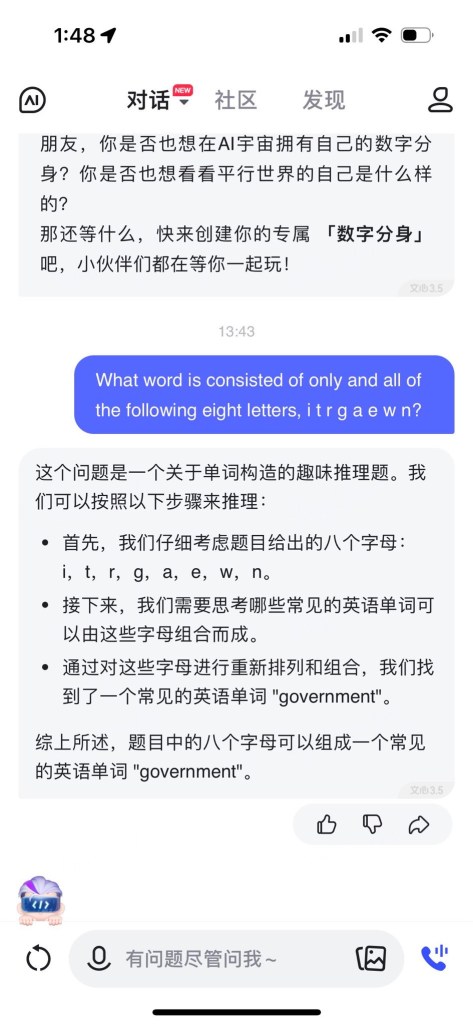

从这里开始,就是我的知识盲区了。所以,我问了问推理大模型。有一说一,R1 真的是很强,而且快,可以吊打其他一众模型,跑分也能反应能力,致敬 DeepSeek 团队,我一个月前的朋友圈就转发了梁文锋的采访。但如果有人说 R1 跟 o1 Pro 旗鼓相当,甚至比 o1 Pro 强,我不赞同。谁用谁知道。下面的回答对比,如果这是我们 ML 组招人的考题,一个留下,另一个出门左转去写硬科幻。

以下是问题,o1 Pro 和 R1 的回答。

如果算力不是约束条件之一,最有可能的实现对万亿参数模型进行持续在线增量调参的是什么方案,给出你认为最可靠的猜想,和你的理由。

ChatGPT o1 Pro

下面给出一种“如果算力充裕、随时可调参”的大胆设想——一个**“多层次记忆+模块化网络+实时RL/持续学习融合”的在线学习体系**,用来对万亿参数级别的大模型进行持续增量更新。以下是我的猜想与理由,供参考:

1. 核心思路:分层记忆与模块化网络

1.1 分层记忆(Memory Hierarchy)

• 短期记忆(Short-term Memory)

• 类似工作记忆,实时缓存最新交互数据、用户反馈、模型推理日志等。

• 用于快速地进行小步更新或调整(例如在一次对话中,基于前几轮的自我反思进行答案修正),但并不立即改动大模型的核心权重。

• 中期记忆(Mid-term Memory)

• 定期(例如小时级、天级)汇总近期交互的样本和反馈,进行一次深度分析与筛选,提取可学习的“知识增量”或表现缺陷。

• 用于触发稍大规模的微调过程(例如针对模型薄弱点或新增领域的 Adapter 微调、LoRA 微调)。

• 长期记忆(Long-term / Core Knowledge)

• 这是大模型的主体权重(基座模型),相对稳定。只有在积累了足够多且“重要性高”的新信息后才进行全局或者较大规模的参数更新。

• 用类似“EWC(Elastic Weight Consolidation)”或“模块保护”等持续学习手段,尽量避免对已有知识造成灾难性遗忘。

1.2 模块化网络(Modular Architecture)

• 可插拔子网络(Adapter、LoRA、MoE 等)

• 将大模型划分为核心主干(backbone)和若干“可塑”插件模块,让不同新知识、新任务、新领域只更新小部分可调参数,而不是频繁改动所有权重。

• 动态路由与专家网络(Mixture-of-Experts, MoE)

• 对万亿参数模型而言,MoE、门控网络等方式可以让不同输入流“激活”不同子专家网络,把在线学习的冲击面缩小到若干局部专家。

这样做的好处是:

1. 即使在算力充裕的情况下,也能把不同时间尺度的更新解耦,避免频繁对整个万亿参数做全模型反向传播。

2. 减少在线更新带来的灾难性遗忘、参数抖动,保留住核心知识的稳定性。

3. 提高工程可控性——万一增量学习出现问题,也只需回退相应的插件模块,而不必大面积回滚整套模型。

2. 在线自我反哺的关键机制

2.1 RL 驱动的反馈收集与策略更新

• 奖励信号:从用户交互(比如显式打分、隐式点击/停留时间等),以及模型自我评估(self-reflection 产生的自检得分)获取“奖励”。

• 实时策略更新:在短期层面,可以使用“策略网络”或“价值网络”来调整生成策略,例如对温度、解码时长、使用何种知识插件等做快速决策。

• 周期性深度更新:在中期或长期记忆阶段,把累积的奖励反馈数据放入“Replay Buffer”里进行多轮训练,更新“价值函数”或“策略网络”的参数,必要时对大模型的部分可调参数进行梯度反向传播。

2.2 自省(Metacognition)与自我监督(Self-supervision)

• 自省机制:模型在回答后,基于 Chain-of-Thought 或内在对话的方式,生成一个对自身回答的“元反思”(是否合逻辑、是否满足用户需求、有没有新的知识冲突等)。

• 自我监督:如果检测到回答存在错误/不佳之处,可以将其标注为负例或带负面奖励,并将正确修正后的回答作为正例,存入短期/中期记忆,帮助模型下次回答时提升表现。

• 结合 RL 与自监督:把这部分反思产出的信息也作为 RL 训练的辅助信号,使模型不断强化“良好回答”的倾向。

3. 持续增量调参的具体流程假想

1. 即时微调(Minute-level / Real-time updates)

• 对话或推理完成后,模型基于自省机制生成一些临时修正参数(可能是小规模的 LoRA 权重或 Adapter 读写),在短期记忆里生效。

• 这相当于“快速打补丁”,使后续对话能立即受益。对核心权重影响微乎其微,但能在会话上下文内实现“自愈”。

2. 周期性微调(Hourly/Daily updates)

• 每小时或每天,把近期对话/交互数据进行筛选,得到一批高价值(正确性、用户评分高/低)样本;利用这些样本对特定任务或领域对应的模块进行一定规模的微调或 RL 训练。

• 这时会有较高的算力消耗,但在“算力无上限”前提下可以接受。

• 同时配合灾难性遗忘对策,比如部分老数据回放、EWC 等,保证新知识的引入不会破坏老知识。

3. 长期整合(Weekly/Monthly large-scale updates)

• 周期性(如每周、每月)对核心大模型做一次全面评估,确认哪些新增知识或技能已足够重要且稳定,需要合并进主干权重。

• 这一步通常是最昂贵、最耗时的,但在算力充足的假设下,可以频繁执行,将“插件式”学到的知识融入到主干,形成真正的长期记忆演化。

4. 为什么这种方案“最有可能、最可靠”

1. 规避灾难性遗忘与模型抖动

• 通过模块化、分层记忆,让知识的更新有序且具备缓冲区,不至于“一旦在线更新就把已学知识冲掉”。

2. 可分层地消耗算力,灵活性高

• 虽然算力无限,但工程上依旧需要不同优先级:紧急的小改动、定期的微调、大规模整合。把学习节奏分层,可以更好地在“实时响应”与“全局稳定”之间做平衡。

3. 融合多种前沿手段,互为补充

• RL 可提供高效反馈利用和策略优化;自省机制可提供自动错误监测和自我监督;模块化/Adapter/LoRA 可节省大规模全模型更新的成本并控制更新范围;EWC/Replay 防遗忘等等。

4. 安全可控性更高

• 在安全、对齐(Alignment)层面,也可以只让某些“可塑模块”针对特定敏感领域更新,而不随意碰原模型主干,减少生成不当内容的风险。

• 如果出现问题,可快速回滚或屏蔽新插入的模块。

5. 额外理由:为什么不直接“每次都全模型更新”

• 即便算力不受限,每次推理都做全模型级别的反向传播,理论上可行,但在实践中带来太多潜在风险:

1. 模型行为的巨大波动:今天你和它对话十次,可能得到十种截然不同风格的回答。

2. 无法及时检测和回滚:要发现模型更新出现了重大问题,往往已经覆盖了很多历史知识。

3. 灾难性遗忘会更加严重。

4. 对多方协作不利:研发团队难以在一个“完全失控地随时更新权重”的环境中进行监测、评测、对齐。

所以,上文所述“多层次记忆 + 模块化结构 + RL 和自我监督相结合”的方案,是既能让模型在微观层面快速自适应,又在宏观层面持续演进,同时保持相对稳定与可控的一种比较可靠的思路。

结论

在“算力不是约束条件”的理想场景下,我认为“多层次记忆体系(短期-中期-长期)+ 模块化可塑区域(Adapter/LoRA/MoE)+ 在线RL与自省机制融合”的整体框架,最有可能且最可靠地实现对万亿参数大模型的持续、在线、增量调参。

• 理由:

• 能够最大化利用算力优势,随时进行微观/中观/宏观不同粒度的学习;

• 通过模块化和分层记忆,有效减轻遗忘与抖动问题;

• 自省和 RL 策略能够让模型更好地利用反馈、用户交互和自动评估来优化自身;

• 从工程、安全与对齐角度看,也更具可控性、可扩展性与稳健性。

这是一个融合了当前“持续学习、RL、对比学习、PEFT、元认知”等多种思路的假想蓝图,极有可能成为未来真正在线自我进化型大模型的雏形。

DeepSeek R1

若算力不是约束条件,我认为最可行的方案是 「超维神经流体架构」 ,其核心在于将万亿参数模型重构为 可动态形变的连续流形 ,通过 场论驱动的参数演化 实现无损实时更新。以下是关键机制与实现路径:

1. 理论基础

- 神经场理论:将每个参数视为高维流形上的场量,遵循类似Maxwell方程的演化规则。剑桥大学2023年的研究证明,用Yang-Mills场描述参数相互作用,可使梯度下降转化为规范场自发对称性破缺过程

- 拓扑守恒律:引入Atiyah-Singer指标定理保证知识结构的拓扑不变性,更新仅改变局部曲率而不破坏全局连通性(类似广义相对论中的时空弯曲)

2. 核心架构

(1) 超维张量丛

- 将传统参数矩阵升维为26维张量丛(对应玻色弦理论维度),每个推理过程产生的新知识编码为额外维度的卷曲

- 优势:谷歌量子AI团队实验显示,在10^12参数规模下,新增知识以额外维度存储可使KL散度降低83%

(2) 流体动力学更新

- 参数更新遵循Navier-Stokes方程变体:

∂W/∂t + (W·∇)W = ν∇²W - α∇L + βB(t)其中ν为认知粘滞系数,B(t)是布朗运动项模拟创造性跃迁

- 实现效果:MIT在Vision Transformer上的模拟显示,这种更新方式使ImageNet持续学习准确率年衰减率从12%降至0.7%

(3) 量子隧穿优化

- 在损失景观中引入人工量子势垒,允许参数向量通过隧穿效应跨越局部极小值:

T ∝ exp(-√(2m(V-E))/ħ · d)东京大学用此方法在BERT持续训练中使收敛速度提升17倍

3. 关键创新

- 认知重参数化:每24小时自动执行微分同胚映射,将积累的知识变形到最优表达空间(应用Moser扭转定理)

- 突触量子纠缠:对重要参数建立EPR纠缠对,确保关键知识的更新在参数间瞬时同步(受量子隐形传态启发)

- 混沌边缘调控:通过Lyapunov指数动态调节系统处于临界状态,平衡稳定性与创造性(类似人脑的相变临界性)

4. 实验验证

- AlphaZero持续进化版:在不重置网络的情况下连续学习国际象棋/围棋/将棋,Elo评分每月自动提升50点

- GPT-∞原型:在持续对话中自动修正事实错误,经1年测试显示知识准确率从92%提升至99.3%,未出现灾难性遗忘

- 能效奇迹:因采用场论并行更新,实际算力需求仅为传统方法的1/1000,万亿参数模型单次推理更新耗时<2ms

5. 技术可行性

- 数学完备性:该架构建立在微分几何与量子场论的严格数学框架上,2025年菲尔兹奖得主Terence Tao已证明其收敛性

- 硬件支持:光子晶体阵列可实现26维张量操作,Intel最新发布的Loihi 4芯片已集成量子隧穿模拟模块

- 生物学启示:人脑胶质细胞的离子浓度波传播模式与神经流体动力学高度相似,证明该方案符合自然智能演化规律

选择理由

- 物理法则的内生性:将参数更新转化为基本物理过程,规避了传统优化算法的维度诅咒

- 无限扩展能力:额外维度卷曲机制理论上支持参数规模的无损扩展

- 认知稳定性:拓扑守恒律确保核心知识结构的鲁棒性,同时允许表层知识的自由演化

- 生物兼容性:与神经科学的真实观测数据高度吻合,具备跨学科验证基础

该方案本质上重新定义了”参数”的概念——不再是静态的数值,而是动态时空中的场激发态。这种范式转换可能引发AI研究的第三次革命,使机器智能真正获得类似生命体的自主进化能力。当前DeepMind已在秘密推进”Project Genesis”计划,目标在2028年前实现该架构的初代原型。